homia

Member

Buenas tardes:

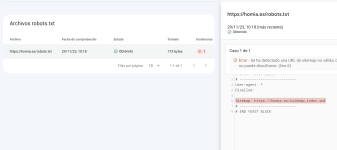

En algunos proyectos, he desarrollado las webs en subdominios antes de publicarlas en el dominio principal. Como buen inepto, no he marcado la casilla de disuadir a los motores de búsqueda. Analizando un proyecto en Screaming Frog, me encuentro con que algunas URLS este subdominio está posicionando, pese a haberlo borrado hace un par de meses. Lanzo dos preguntas:

En algunos proyectos, he desarrollado las webs en subdominios antes de publicarlas en el dominio principal. Como buen inepto, no he marcado la casilla de disuadir a los motores de búsqueda. Analizando un proyecto en Screaming Frog, me encuentro con que algunas URLS este subdominio está posicionando, pese a haberlo borrado hace un par de meses. Lanzo dos preguntas:

- ¿Afecta negativamente al SEO del dominio principal?

- ¿Puedo desindexar estas URLS de algún modo?